Reinforcement Learning: Pengertian, Karakteristik, dan Cara Kerjanya

Selain supervised dan unsupervised learning, ada juga metode pembelajaran lain pada machine learning. Metode tersebut adalah reinforcement learning.

Apa itu reinforcement learning?

Kita akan belajar memahaminya bersama-sama melalui artikel berikut. Simak baik-baik, ya!

Pengertian Reinforcement Learning

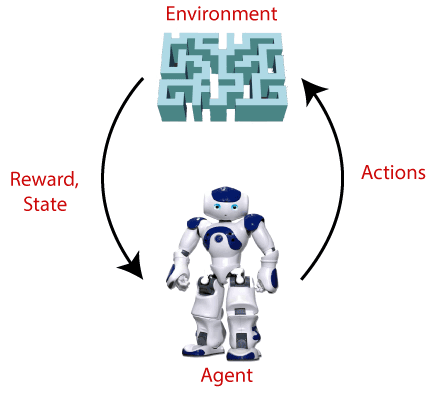

Reinforcement learning merupakan metode machine learning berbasis umpan balik di mana agen belajar berperilaku di lingkungan dengan melakukan tindakan dan melihat hasil tindakan. Untuk setiap tindakan baik, agen mendapat umpan balik positif, dan untuk setiap tindakan buruk, agen mendapat umpan balik negatif atau penalti.

Dalam reinforcement learning, agen belajar secara otomatis menggunakan umpan balik tanpa data berlabel, tidak seperti metode pembelajaran supervised learning. Karena tidak ada data berlabel, maka agen terikat untuk belajar dari pengalamannya saja.

Reinforcement learning memecahkan jenis masalah tertentu di mana pengambilan keputusan berurutan, dan tujuannya adalah jangka panjang, seperti bermain game, robotika, dll.

Agen pada reinforcement learning berinteraksi dengan lingkungan dan mengeksplorasinya sendiri. Tujuan utama seorang agen dalam reinforcement learning adalah untuk meningkatkan kinerja dengan mendapatkan imbalan positif yang maksimal.

Agen belajar dengan proses hit and trial, dan berdasarkan pengalaman, ia belajar untuk melakukan tugas dengan cara yang lebih baik.

Kesimpulannya, reinforcement learning adalah jenis metode pembelajaran mesin di mana agen cerdas (program komputer) berinteraksi dengan lingkungan dan belajar untuk bertindak di dalamnya.

|

| Sumber: javatpoint.com |

Misalkan ada agen AI yang hadir dalam lingkungan labirin, dan tujuannya adalah untuk menemukan berlian. Agen berinteraksi dengan lingkungan dengan melakukan beberapa tindakan, dan berdasarkan tindakan tersebut, keadaan agen berubah, dan juga menerima imbalan atau penalti sebagai umpan balik.

Agen terus melakukan tiga hal ini (mengambil tindakan, mengubah keadaan/tetap dalam keadaan yang sama, dan mendapatkan umpan balik), dan dengan melakukan tindakan ini, ia belajar dan menjelajahi lingkungan.

Agen belajar bahwa tindakan apa yang mengarah pada umpan balik atau imbalan positif dan tindakan apa yang mengarah pada hukuman umpan balik negatif. Sebagai imbalan positif, agen mendapat poin positif, dan sebagai penalti, agen mendapat poin negatif.

Istilah yang Digunakan dalam Reinforcement Learning

|

| Sumber: researchgate.net |

- Agent: Entitas yang dapat melihat/menjelajahi lingkungan dan bertindak berdasarkan itu.

- Environment: Lingkungan atau situasi di mana agen hadir atau dikelilingi olehnya. Di RL, kita mengasumsikan lingkungan bersifat stokastik atau acak.

- Action: Action adalah gerakan yang diambil oleh agen dalam lingkungan.

- State: State adalah situasi yang dikembalikan oleh lingkungan setelah setiap tindakan yang dilakukan oleh agen.

- Reward: Umpan balik yang dikembalikan ke agen dari lingkungan untuk mengevaluasi tindakan agen.

- Policy: Policy adalah strategi yang diterapkan oleh agen untuk tindakan selanjutnya berdasarkan keadaan saat ini.

- Value: Imbalan jangka panjang yang diharapkan dengan faktor diskon dan kebalikan dari imbalan jangka pendek.

- Q-value: Q-value sebagian besar mirip dengan value, tetapi dibutuhkan satu parameter tambahan sebagai tindakan saat ini (a).

Karakteristik Reinforcement Learning

Berikut ini adalah karakteristik dari reinforcement learning:

- Pada reinforcement learning, agen tidak diinstruksikan tentang lingkungan dan tindakan apa yang perlu dilakukan.

- Reinforcement learning didasarkan pada proses hit and trial.

- Agen mengambil tindakan berikutnya dan mengubah status sesuai dengan umpan balik dari tindakan sebelumnya.

- Agen bisa saja mendapatkan imbalan yang tertunda.

- Lingkungan adalah stokastik, dan agen perlu menjelajah untuk mencapainya dan untuk mendapatkan imbalan positif yang maksimal.

Pendekatan pada Reinforcement Learning

Ada tiga cara utama untuk menerapkan reinforcement learning pada machine learning, yaitu:

1. Berbasis nilai

Pendekatan berbasis value atau nilai adalah pendekatan dengan menemukan fungsi nilai optimal, yang merupakan nilai maksimum pada suatu keadaan di bawah kebijakan apa pun.

Oleh karena itu, agen mengharapkan imbalan jangka panjang di keadaan apapun berdasarkan policy (kebijakan).

2. Berbasis policy (kebijakan)

Pendekatan berbasis kebijakan adalah untuk menemukan kebijakan yang optimal untuk imbalan masa depan yang maksimal tanpa menggunakan fungsi nilai.

Dalam pendekatan ini, agen mencoba menerapkan kebijakan sedemikian rupa sehingga tindakan yang dilakukan di setiap langkah membantu memaksimalkan imbalan di masa depan.

Pendekatan berbasis kebijakan memiliki dua jenis kebijakan:

- Deterministik: Tindakan yang sama dihasilkan oleh kebijakan (π) di keadaan apa pun.

- Stokastic: Dalam kebijakan ini, probabilitas menentukan tindakan yang dihasilkan.

3. Berbasis model

Dalam pendekatan berbasis model, model virtual dibuat untuk lingkungan, dan agen menjelajahi lingkungan itu untuk mempelajarinya.

Tidak ada solusi atau algoritma khusus untuk pendekatan ini karena representasi model berbeda untuk setiap lingkungan.

Komponen-komponen pada Reinforcement Learning

Ada empat elemen utama reinforcement learning, yaitu:

- Kebijakan (Policy)

- Sinyal Imbalan (Reward Signal)

- Fungsi Nilai

- Model lingkungan

1. Kebijakan (Policy)

Kebijakan dapat didefinisikan sebagai cara bagaimana agen berperilaku pada waktu tertentu. Elemen ini memetakan keadaan lingkungan yang dirasakan ke tindakan yang diambil pada keadaan tersebut.

Kebijakan (policy) adalah elemen inti dari reinforcement learning karena kebijakan itu sendiri dapat menentukan perilaku agen.

Dalam beberapa kasus, kebijakan dapat berupa fungsi sederhana atau tabel pencarian, sedangkan untuk kasus lain, mungkin melibatkan perhitungan umum sebagai proses pencarian.

Kebijakan dapat berupa deterministik atau stokastik:

Untuk kebijakan deterministik: a = (s)

Untuk kebijakan stokastik: (a | s) = P[At =a | st = s]

2. Sinyal Imbalan (Reward signal)

Tujuan reinforcement learning ditentukan oleh sinyal imbalan. Pada setiap keadaan, lingkungan mengirimkan sinyal langsung ke agen, dan sinyal ini dikenal sebagai sinyal imbalan.

Imbalan atau reward ini diberikan sesuai dengan perbuatan baik dan buruk yang dilakukan oleh agen. Tujuan utama agen adalah untuk memaksimalkan jumlah total imbalan untuk tindakan yang baik.

Sinyal imbalan dapat mengubah kebijakan, seperti jika tindakan yang dipilih oleh agen mengarah ke imabalan yang rendah, maka kebijakan tersebut dapat berubah untuk memilih tindakan lain di masa mendatang.

3. Fungsi Nilai

Fungsi nilai memberikan informasi tentang seberapa baik situasi dan tindakan, juga berapa banyak imbalan yang dapat diharapkan oleh agen.

Imbalan menunjukkan sinyal langsung untuk setiap tindakan baik dan buruk, sedangkan fungsi nilai menentukan keadaan dan tindakan baik untuk masa depan.

Fungsi nilai bergantung pada imbalan karena, tanpa imbalan, tidak akan ada nilai. Tujuan dari memperkirakan nilai adalah untuk mencapai lebih banyak imbalan.

4. Model

Elemen terakhir dari reinforcement learning adalah model, yang meniru perilaku lingkungan. Dengan bantuan model, seseorang dapat membuat kesimpulan tentang bagaimana lingkungan akan berperilaku.

Seperti misalnya jika suatu keadaan dan suatu tindakan diberikan, maka sebuah model dapat memprediksi keadaan dan imbalan berikutnya.

Model digunakan untuk perencanaan, yang berarti menyediakan cara untuk mengambil tindakan dengan mempertimbangkan semua situasi masa depan sebelum benar-benar mengalami situasi tersebut.

Pendekatan untuk memecahkan masalah reinforcement learning dengan bantuan model disebut sebagai pendekatan berbasis model. Secara komparatif, pendekatan tanpa menggunakan model disebut pendekatan bebas model.

Jenis-jenis Reinforcement Learning

Pada dasarnya ada dua jenis reinforcement learning, yaitu:

- Reinforcement positif

- Reinforcement negatif

Reinforcement positif

Reinforcement positif berarti menambahkan sesuatu untuk meningkatkan kecenderungan bahwa perilaku yang diharapkan akan terjadi lagi. Ini berdampak positif pada perilaku agen dan meningkatkan kekuatan perilaku tersebut.

Jenis reinforcement ini dapat mempertahankan perubahan untuk waktu yang lama, tetapi terlalu banyak reinforcement positif dapat menyebabkan kelebihan keadaan yang dapat mengurangi konsekuensinya.

Reinforcement negatif

Reinforcement negatif berlawanan dengan reinforcement positif karena meningkatkan kecenderungan bahwa perilaku tertentu akan terjadi lagi dengan menghindari kondisi negatif.

Reinforcement jenis ini bisa lebih efektif daripada reinforcement positif tergantung pada situasi dan perilaku, tetapi reinforcement ini hanya diberikan untuk memenuhi perilaku minimum.

Cara Kerja Reinforcement Learning

Reinforcement learning (RL) melibatkan agen untuk menjelajahi lingkungan yang tidak diketahui dan mencapai tujuan. RL didasarkan pada hipotesis bahwa semua tujuan dapat dijelaskan dengan memaksimalkan imbalan kumulatif yang diharapkan.

Agen harus belajar merasakan dan mengganggu keadaan lingkungan menggunakan tindakannya untuk mendapatkan imbalan maksimal.

Tujuan dari algoritma reinforcement learning adalah untuk menemukan kebijakan tindakan yang memaksimalkan nilai rata-rata yang dapat diekstraksi dari setiap keadaan sistem.

Untuk memahami proses kerja reinforcement learning, kita perlu memperhatikan dua hal utama:

- Lingkungan: Ini bisa berupa apa saja seperti ruangan, labirin, lapangan sepak bola, dll.

- Agen: Agen cerdas seperti robot AI.

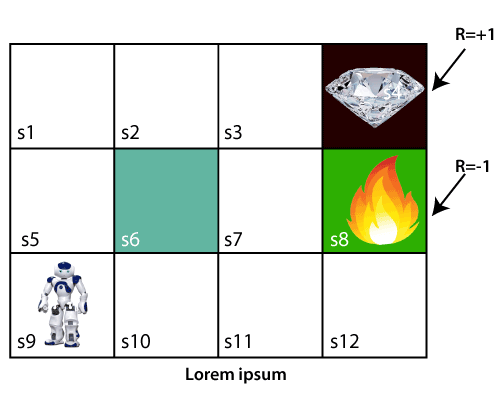

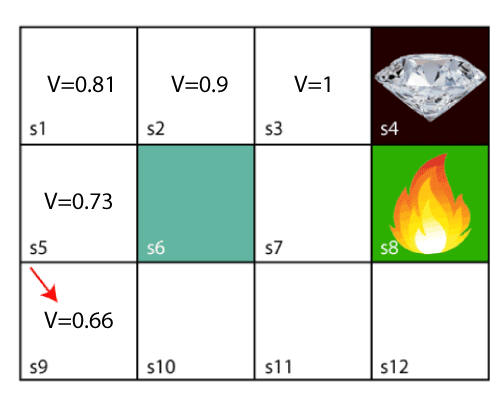

Mari kita ambil contoh lingkungan labirin yang perlu dijelajahi oleh agen. Perhatikan gambar di bawah ini:

|

| Sumber: javatpoint.com |

Pada gambar di atas, agen berada di blok pertama labirin. Labirin terdiri dari blok S6, yang merupakan dinding, S8 adalah lubang api, dan S4 adalah blok berlian.

Agen tidak dapat melewati blok S6, karena merupakan dinding yang kokoh. Jika agen mencapai blok S4, maka akan mendapat imbalan +1; jika mencapai lubang api, maka mendapat imbalan poin -1.

Agen dapat mengambil empat tindakan: bergerak ke atas, bergerak ke bawah, bergerak ke kiri, dan bergerak ke kanan.

Agen dapat mengambil jalan apa pun untuk mencapai titik akhir, tetapi ia perlu melakukannya dengan langkah yang paling sedikit.

Misalkan agen mempertimbangkan jalur S9-S5-S1-S2-S3, maka dia akan mendapatkan poin imbalan +1.

Agen akan mencoba mengingat langkah-langkah sebelumnya yang telah diambil untuk mencapai langkah terakhir.

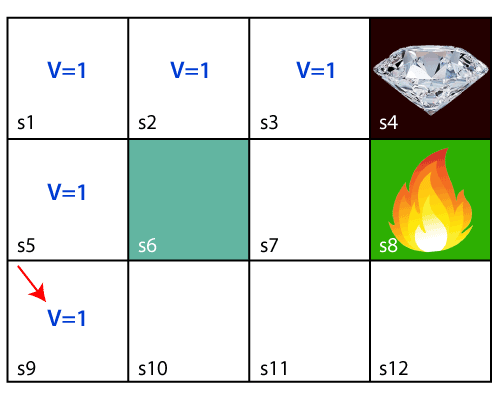

Untuk menghafal langkah-langkah, agen memberikan nilai 1 untuk setiap langkah sebelumnya. Pertimbangkan langkah di bawah ini:

|

| Sumber: javatpoint.com |

Sekarang, agen telah berhasil menyimpan langkah sebelumnya dengan menetapkan nilai 1 untuk setiap blok sebelumnya.

Tapi apa yang akan agen lakukan jika dia ingin bergerak dari blok, tetapi di kedua sisi blok bernilai 1? Blok yang mana yang akan dipilih?

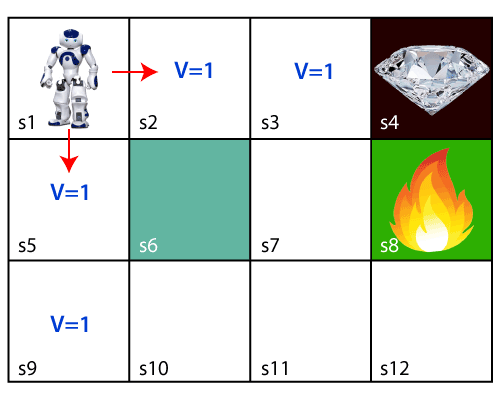

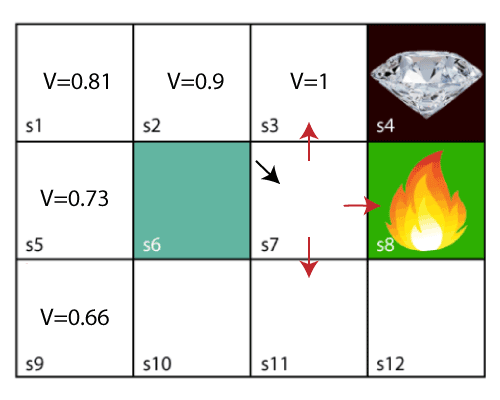

Perhatikan diagram di bawah ini:

|

| Sumber: javatpoint.com |

Kasus ini akan menjadi kondisi yang sulit bagi agen apakah ia harus naik atau turun karena setiap blok memiliki nilai yang sama.

Jadi, pendekatan di atas tidak cocok bagi agen untuk mencapai tujuan. Oleh karena itu untuk memecahkan masalah ini, kita akan menggunakan persamaan Bellman, yang merupakan konsep utama di balik reinforcement learning.

Persamaan Bellman diperkenalkan oleh matematikawan Richard Ernest Bellman pada tahun 1953, dan karenanya disebut sebagai persamaan Bellman.

Persamaan Bellman terkait dengan pemrograman dinamis dan digunakan untuk menghitung nilai masalah keputusan pada titik tertentu dengan memasukkan nilai-nilai keadaan sebelumnya.

Persamaan ini menghitung fungsi nilai dalam pemrograman dinamis atau lingkungan yang mengarah ke reinforcement learning modern.

Elemen kunci yang digunakan dalam persamaan Bellman adalah:

- Tindakan yang dilakukan oleh agen disebut sebagai "a"

- Keadaan yang terjadi ketika melakukan tindakan adalah "s."

- Imbalan/umpan balik yang diperoleh untuk setiap tindakan baik dan buruk adalah "R."

- Faktor diskon adalah Gamma "γ."

Persamaan Bellman dapat ditulis sebagai:

V(s) = maks [R(s,a) + γV(s`)]

Di mana,

- V(s) = nilai yang dihitung pada titik tertentu.

- R(s,a) = Imbalan pada keadaan tertentu s ketika melakukan suatu tindakan.

- γ = Faktor diskon

- V(s`) = Nilai pada keadaan sebelumnya.

Dalam persamaan di atas, kita mengambil nilai maksimal dari nilai lengkap karena agen selalu berusaha mencari solusi optimal.

Dengan menggunakan persamaan Bellman di atas, kita akan menemukan nilai pada setiap keadaan lingkungan yang diberikan. Kita akan mulai dari blok yang berada di sebelah blok target.

Untuk blok 1:

V(s3) = max [R(s,a) + V(s`)], di sini V(s')= 0 karena tidak ada keadaan lebih lanjut untuk dipindahkan.

V(s3)= max[R(s,a)]=> V(s3)= max[1]=> V(s3)= 1.

Untuk blok ke-2:

V(s2) = max [R(s,a) + V(s`)], di sini = 0.9(let), V(s')= 1, dan R(s, a)= 0, karena ada tidak ada imbalan di keadaan ini.

V(s2)= maks[0,9(1)]=> V(s)= maks[0,9]=> V(s2) =0,9

Untuk blok ke-3:

V(s1) = max [R(s,a) + V(s`)], di sini = 0.9(let), V(s')= 0.9, dan R(s, a)= 0, karena ada tidak ada imbalan di keadaan ini juga.

V(s1)= maks[0.9(0.9)]=> V(s3)= maks[0.81]=> V(s1) =0.81

Untuk blok ke-4:

V(s5) = max [R(s,a) + V(s`)], disini = 0.9(let), V(s')= 0.81, dan R(s, a)= 0, karena ada tidak ada imbalan di keadaan ini juga.

V(s5)= maks[0.9(0.81)]=> V(s5)= maks[0.81]=> V(s5) =0.73

Untuk blok ke-5:

V(s9) = max [R(s,a) + V(s`)], di sini = 0.9(let), V(s')= 0.73, dan R(s, a)= 0, karena ada tidak ada imbalan di keadaan ini.

V(s9)= maks[0.9(0.73)]=> V(s4)= maks[0.81]=> V(s4) =0.66

Perhatikan gambar di bawah ini:

|

| Sumber: javatpoint.com |

Sekarang, kita akan bergerak lebih jauh ke blok ke-6, dan di sini agen dapat mengubah rute karena agen harus berusaha mencari jalur yang optimal.

Mari kita pertimbangkan blok di sebelah lubang api.

|

| Sumber: javatpoint.com |

Sekarang, agen memiliki tiga opsi untuk pindah; jika dia pindah ke kotak biru, maka dia akan berbenturan dengan tembok, jika dia pindah ke lubang api, maka dia akan mendapatkan imbalan -1.

Karena di sini kita hanya mengambil imbalan positif, maka agen akan naik ke atas saja. Nilai blok lengkap akan dihitung menggunakan rumus yang sudah kita gunakan sebelumnya.

|

| Sumber: javatpoint.com |

Penutup

Demikianlah penjelasan mengenai reinforcement learning. Semoga informasi yang disajikan dapat bermanfaat dan membantu Anda memahami lebih jauh mengenai reinforcement learning.

Apabila Anda suka dengan artikel seperti ini, Anda bisa mengunjungi rubrik Kecerdasan Buatan, atau membaca artikel lainnya mengenai "Sistem Pakar".

Salam!

Referensi: https://www.javatpoint.com/reinforcement-learning

Posting Komentar untuk "Reinforcement Learning: Pengertian, Karakteristik, dan Cara Kerjanya"

Komentar SPAM akan disensor. Harap gunakan kalimat yang tidak menjurus pada SARA dan pornografi.