Pengertian dan Teknik Data Preprocessing dalam Data Mining

Data yang diambil secara primer (data mentah) terkadang memiliki inkonsistensi, noise, informasi yang kurang lengkap, dan nilai yang hilang. Biasanya data dikumpulkan dari sumber yang beragam menggunakan data mining dan teknik data warehouse.

Merupakan aturan umum dalam machine learning bahwa semakin besar jumlah data yang kita miliki, semakin baik model yang dapat kita latih.

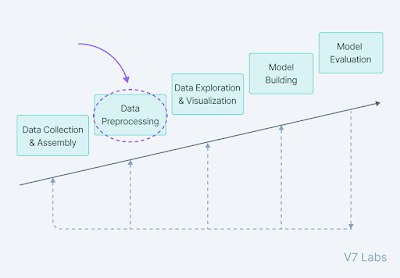

Pada artikel ini, akan dibahas langkah-langkah data preprocessing yang perlu diikuti untuk mengubah data mentah menjadi data dalam bentuk olahan.

Pengertian Data Preprocessing

Data preprocessing adalah teknik pengolahan data yang mencakup langkah-langkah yang perlu kita ikuti untuk mengubah atau mengkodekan data sehingga dapat dengan mudah diuraikan oleh mesin.

Data preprocessing merupakan komponen dalam persiapan data, yang mendeskripsikan semua jenis pemrosesan yang dilakukan pada data mentah agar siap dilakukan pemrosesan data lanjutan, seperti visualisasi data dan pembentukan model.

Preprocessing data berfungsi untuk mengubah data menjadi format yang lebih mudah dan efektif. Proses ini menjadi langkah awal yang penting dalam upaya data mining. Selain itu, teknik data preprocessing juga telah diadaptasi untuk melatih model machine learning.

Ada beberapa metode yang digunakan untuk data preprocessing, seperti:

- sampling: memilih subset yang representatif dari populasi data yang besar

- transformasi: memanipulasi data mentah untuk menghasilkan satu input

- denoising: menghilangkan noise dari data

- imputasi: mensintesis data yang relevan secara statistik untuk nilai yang hilang

- normalisasi: mengatur data untuk akses yang lebih efisien

- ekstraksi fitur: mengeluarkan subset fitur relevan yang signifikan dalam konteks tertentu.

|

| Sumber: v7labs.com |

Mengapa Data Preprocessing Penting?

Mayoritas kumpulan data untuk machine learning sangat rentan hilang, tidak konsisten, noise karena asalnya yang heterogen.

Menerapkan algoritma data mining pada data yang noise tidak akan memberikan hasil yang baik karena akan gagal mengidentifikasi pola secara efektif. Pengolahan data atau data processing penting untuk meningkatkan kualitas data secara keseluruhan.

Berikut adalah beberapa alasan yang mendasari pentingnya data preprocessing:

- Nilai duplikat atau hilang dapat memberikan asumsi yang salah tentang statistik data secara keseluruhan.

- Titik data yang tidak konsisten dan outlier sering cenderung mengganggu pembelajaran model secara keseluruhan, yang mengarah pada prediksi yang salah.

- Keputusan yang berkualitas harus didasarkan pada data yang berkualitas. Data preprocessing penting untuk mendapatkan data berkualitas ini, yang tanpanya hanya akan menjadi skenario "Garbage In, Garbage Out", yang artinya kalau kita memasukkan data yang jelek pada model, maka keluarannya juga akan jelek.

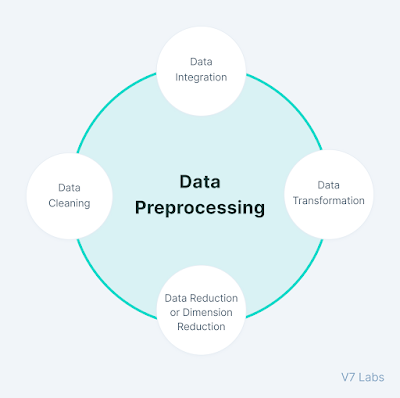

Empat Langkah pada Data Preprocessing

|

| Sumber: v7labs.com |

Berikut langkah-langkah yang digunakan pada data preprocessing:

1. Data Cleaning

Data cleaning atau pembersihan data terutama dilakukan sebagai bagian dari data preprocessing untuk membersihkan data dengan mengisi nilai yang hilang, menghaluskan data yang noise, menyelesaikan data yang tidak konsisten, dan menghapus outlier.

Nilai yang hilang

Berikut beberapa cara yang dapat menyelesaikan masalah ini:

- Mengabaikan tuple

Metode ini harus dipertimbangkan ketika dataset sangat besar dan banyak nilai yang hilang dalam sebuah tuple. - Mengisi nilai yang hilang

Ada banyak metode untuk menyelesaikan masalah ini, seperti mengisi nilai secara manual, memprediksi nilai yang hilang dengan menggunakan metode regresi, atau metode numerik seperti atribut mean.

Data noisy

Proses ini melibatkan penghapusan kesalahan acak atau varians dalam variabel yang diukur. Hal ini dapat dilakukan dengan bantuan teknik berikut:

- Binning

Teknik ini bekerja pada nilai data yang diurutkan untuk menghaluskan noise yang ada didalamnya. Data dibagi menjadi bin (tempat sampah) yang berukuran sama, dan setiap bin ditangani secara independen. Semua data pada sebuah segmen dapat diganti dengan nilai mean, median, atau boundary. - Regresi

Teknik data mining ini pada umumnya digunakan untuk prediksi. Ini membantu untuk menghaluskan noise dengan menyesuaikan semua titik data dalam fungsi regresi. Persamaan regresi linear digunakan jika hanya ada satu atribut independen, lain dengan persamaan polinomial yang digunakan. - Clustering

Pembuatan kelompok/cluster dari data yang memiliki nilai serupa. Nilai-nilai yang tidak terletak di cluster dapat diperlakukan sebagai data yang noise dan dapat dihapus.

Menghapus outlier

Teknik clustering yang mengelompokkan titik-titik data yang serupa. Tuple yang terletak di luar cluster adalah data outlier/tidak konsisten.

2. Integrasi Data

Integrasi data adalah salah satu langkah data preprocessing yang digunakan untuk menggabungkan data yang ada di berbagai sumber menjadi satu penyimpanan data yang lebih besar seperti gudang data atau data warehouse.

Integrasi data dibutuhkan terutama ketika kita bertujuan untuk memecahkan skenario seperti mendeteksi keberadaan modul dari gambar CT scan. Satu-satunya pilihan adalah mengintegrasi gambar dari beberapa node medis untuk membentuk database yang lebih besar.

Kita mungkin mengalami beberapa masalah saat mengadopsi integrasi data sebagai salah satu langkah data preprocessing:

- Integrasi skema dan pencocokan objek: Data dapat hadir dalam format yang berbeda, dan atribut yang mungkin menyebabkan kesulitan dalan integrasi data.

- Menghapus atribut yang berlebihan atau redundan dari semua sumber data.

- Deteksi dan resolusi konflik nilai data.

3. Transformasi Data

Setelah pembersihan data dilakukan, kita perlu mengkonsolidasikan data berkualitas ke dalam bentuk alternatif dengan mengubah nilai, struktur, atau format data meggunakan strategi transformasi data berikut ini.

Generalisasi

Data tingkat rendah atau granular yang telah dikonversi menjadi informasi tingkat tinggi dengan menggunakan konsep hirarki. Kita dapat mengubah data primitif di alamat seperti kota menjadi informasi tingkat tinggi seperti negara.

Normalisasi

Teknik ini adalah teknik transformasi data yang paling penting yang banyak digunakan. Atribut numerik ditingkatkan atau diturunkan agar sesuai dengan rentang yang ditentukan.

Dalam pendekatan ini, kita membatasi atribut data untuk mengembangkan korelasi diantara titik data yang berbeda. Normalisasi data dapat dilakukan dengan berbagai cara, sebagai berikut.

- Normalisasi Min-max

- Normaliasasi Z-Score

- Normalisasi Decimal Scaling

Seleksi atribut

Properti data baru dibuat dari atribut yang ada untuk membantu dalam proses data mining. Misalnya, tanggal lahir, atribut data dapat diubah ke properti lain seperti is_senior_citizen untuk setiap tuple, yang secara langsung memengaruhi prediksi penyakit atau peluang bertahan hidup, dll.

Agregari atau pengumpulan

Metode ini menyimpan data dalam format ringkasan. Misalnya penjualan, data dapat digabungkan dan diubah untuk ditampilkan sesuai format bulan dan tahun.

4. Data Reduction

Ukuran dataset di data warehouse bisa terlalu besar untuk ditangani oleh analisis data dan algoritma data mining.

Salah satu solusi yang bisa diambil adalah mendapatkan representasi tereduksi dari dataset yang volumenya jauh lebih kecil tetapi menghasilkan kualitas hasil analitik yang sama.

Berikut adalah cara dari berbagai strategi reduksi data:

Data cube aggregation

Ini merupakan cara reduksi data, yang mana data dikumpulkan yang dinyatakan dalam bentuk ringkasan. Operasi agregasi diterapkan pada data dalam konstruksi kubus data.

Dimensionality reduction

Teknik dimensionality reduction digunakan untuk melakukan ektraksi fitur/ciri. Dimasi dataset mengacu pada atribut atau fitur infividu dari data. Teknik ini bertujuan untuk mengurangi jumlah fitur yang redundan. Pengurangan dimensi dapat dilakukan dengan menggunakan teknik seperti Principal Componen Analysis, dll.

Data compression

Dengan menggunakan teknologi encoding, ukuran data dapat dikurangi secara signifikan. Tetapi mengompresi data dapat berupa lossy atau non-lossy.

Jika data asli dapat diperoleh setelah rekonstruksi dari data terkompresi, maka disebut sebagai reduksi lossless, jika tidak, maka disebut sebagai reduksi lossy.

Discretization

Diskritisasi data digunakan untuk membagi atribut-atribut yang sifatnya kontinu menjadi data dengan interval.

Hal ini dilakukan karena fitur nilai kontinu cenderung memiliki peluang korelasi yang lebih kecil dengan variabel target. Hal ini karena kita akan kesulitan untuk menafsirkan hasilnya.

Setelah diskritisasi variabel, kelompok yang sesuai dengan target dapat diinterpretasikan. Misalnya, atribut usia dapat didiskritkan ke dalam format seperti di bawah 18, 18-44, 44-60, diatas 60.

Numerosity reduction

Data dapat direpresentasikan sebagai model atau persamaan seperti model regresi. Ini akan menghemat beban penyimpanan kumpulan data besar alih-alih model.

Attribute subset selection

Sangat penting untuk menjadi spesifik dalam pemilihan atribut. Jika tidak, ini dapat menyebabkan data berdimensi tinggi, yang sulit untuk dilatih karena masalah underfitting/overfitting. Hanya atribut yang menambah nilai lebih terhadap model pelatihan yang harus dipertimbangkan, dan sisanya semua dapat dibuang.

Penilaian Kualitas Data

Penilaian kualitas data mencakup pendekatan statistik yang perlu diikuti untuk memastikan bahwa data tidak memiliki masalah.

Data digunakan untuk operasi, manajemen pelanggan, analisis pemasaran, dan pengambilan keputusan. Oleh karena itu, data harus berkualitas tinggi.

Komponen utama dalam penilaian kualitas data meliputi:

- Kelengkapan tanpa nilai atribut yang hilang

- Akurasi dan keandalan dalam hal informasi

- Konsistensi dalam semua fitur

- Menjaga validitas data

- Tidak mengandung redundansi apa pun

Ringkasan Data Preprocessing

- Langkah pertama dalam data preprocessing adalah memahami data. Hanya dengan melihat dataset, kita dapat menggunakan intuisi untuk menentukan hal-hal apa yang perlu difokuskan.

- Gunakan metode statistik atau library bawaan yang membantu kita memvisualisasikan dataset dan memberi gambaran jelas mengenai data terutama dalam hal distribusi kelas.

- Ringkas data jika terdapat data duplikat, nilai yang hilang, dan outlier yang ada dalam data.

- Buang atribut atau fitur yang dirasa tidak berguna untuk pemodelan. Pengurangan dimensi menjadi salah satu aspek yang sangat penting dari data preprocessing.

- Lakukan beberapa rekayasa fitur dan cari tahu atribut mana yang paling berkontribusi terhadap pelatihan model.

Penutup

Demikianlah penjelasan lengkap mengenai data preprocessing yang biasanya ada dalam machine learning dan data mining. Semoga informasi yang disajikan dapat bermanfaat dan menambah khazanah ilmu pengetahuan kita mengenai teknik-teknik data preprocessing.

Apabila Anda suka dengan artikel ini, jangan lupa share ke rekan-rekan Anda di media sosial, atau kunjungi rubrik Data Science untuk artikel-artikel menarik lainnya.

Salam!

Referensi:

Posting Komentar untuk "Pengertian dan Teknik Data Preprocessing dalam Data Mining"

Komentar SPAM akan disensor. Harap gunakan kalimat yang tidak menjurus pada SARA dan pornografi.